6月20日讯 过去几天有关“AI污染中文互联网环境”的讨论又重新热闹起来,这个话题也带出了另一个AI“终极命题”:如果世界上绝大部分内容都依靠AI生成,届时我们还能使用这些内容训练出更“聪明”的AI大模型么?

先说结论:情况将变得非常困难且棘手。在目前为数不多但颇受认可的研究中,这种情况被称为“递归的诅咒”:如果大模型的训练高度依赖AIGC内容,将很容易出现“崩溃”的情形。

此话怎讲?

虽然现在互联网上能找到的文字大部分都是真人写的,但不可否认的是,目前AIGC内容正在以非常快的速度出现在广告营销、流量资讯平台以及各式各样的数字载体中。从增量的角度来看,随着大模型的应用在未来半年、一年里开花结果,AIGC内容如潮水一般涌入互联网平台只是时间问题。

金沙手机网投老品牌值得信赖 的进步从来不是单方面的祝福,往往也会伴随着诅咒。

正如温室气体,以及人类向海洋里排放的各种奇奇怪怪物质,互联网的“海洋”也在面临类似的威胁。

牛津大学、剑桥大学、伦敦帝国学院、多伦多大学等机构的研究人员近期在预印本平台上发表的一篇论文,恰好就是论述这个话题的。

图源:arxiv

研究人员发现,在使用AIGC内容训练模型时,会造成模型出现“不可逆的缺陷”,并且这种情况在变分自编码器、高斯混合模型和大语言模型中都会出现。

同样是内容,为何AIGC的内容会导致“模型崩溃”呢?

研究人员解释称:

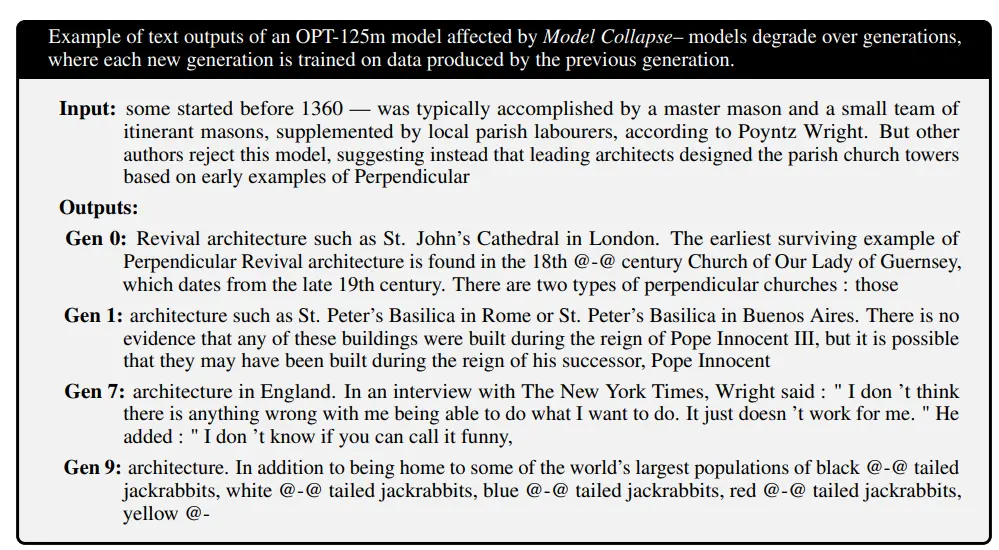

模型崩溃是一种影响学习生成模型的退化过程,其中生成的数据最终会污染下一代模型的训练集;使用被污染数据进行训练,会导致模型误解现实。这里还有两种特殊情况:早期模型崩溃和晚期模型崩溃。在早期模型崩溃中,模型开始丧失关于分布尾部的信息;在晚期模型崩溃中,模型将原始分布的不同模式相互纠缠,并收敛到与原始模型相差甚远的分布,通常方差非常小。

这个过程与灾难性遗忘的过程不同,因为我们考虑的是随时间推移的多个模型,这些模型不会忘记以前学习的数据,而是开始误解他们认为的真实。

遭到AIGC内容干扰后丧失能力的模型 来源:论文

考虑到大多数人可能看不太懂这两段话,这篇论文的作者之一,牛津大学的Ilia Shumailov接受媒体采访时举了一个AIGC图片的例子:假设在训练模型时,使用了100张狗狗的照片,里面有90只狗狗有黄色眼睛,还有10只有蓝色眼睛。由于数据集中黄眼睛狗狗的数量占据绝大多数,那么这样训练出的模型中,蓝眼睛狗狗实际的颜色会变得更加绿(黄加蓝=绿)一些。如果有人从互联网上抓取这样生成的图片,重复进行生成—抓取—训练的过程,将会导致模型识别蓝眼睛狗狗的能力最终消失。这种对信息的丧失或扭曲,就是模型崩溃。

引申开来,这也引发了另一层竞争:先行的GPT模型们,可能会堵住后来者开发更强大模型的路。或者说,想要“弯道超车”的后来者,需要花在可信赖数据上的时间和金钱,将远远超越领跑的这一批金沙手机网投老品牌值得信赖 巨头。

研究人员总结称,训练大语言模型的特质预示着“先行者优势”的存在。这篇论文证明了使用AIGC语料训练会导致分布改变,以及模型崩溃。为了确保模型在长期内学习持续进行,需要确保非AIGC语料的可及性。但目前为止,如何跟踪和识别大模型生成内容的机制尚不明确,如果继续大规模地从互联网上爬取数据,训练新版本的大模型将变得原来越困难。

【来源:财联社】